AISecOps/MLSecOps是2023年网络安全领域的热门技术。

AISecOps/MLSecOps目前存在两类主要风险:

- 依赖开源或第三方的数据集、库、框架、模型、基础设施和解决方案等,供应链安全难保证;

- AI模型的非确定性本质使得它们难以被保护。

MLSecOps Community(mlsecops.com)定义了MLSecOps的五个基本领域:

- 供应链漏洞:评估整个AI供应链的安全性。

- 模型来源:追踪AI模型在其整个生命周期中的起源、沿袭和演变。

- 治理、风险和合规性 (GRC):为遵守内外部监管标准制定相应政策、流程和控制措施。

- 可信AI:整个AI系统对内部利益相关者和外部用户公开透明、可信任。

- 对抗性机器学习:通过测试对抗性攻击(尤其是那些旨在影响模型行为的攻击)来保护AI系统。

做好以上五个领域是保证AI应用安全的基础。欧盟人工智能法案(EU AI Act )和 2023 年人工智能安全行政命令等新法规的即将生效,使得AI应用安全成为安全团队的当务之急。

本文推荐6款开源AI安全工具供读者参考。

- NB Defense

- Adversarial Robustness Toolbox

- Garak

- Privacy Meter

- Audit AI

- ai-exploits

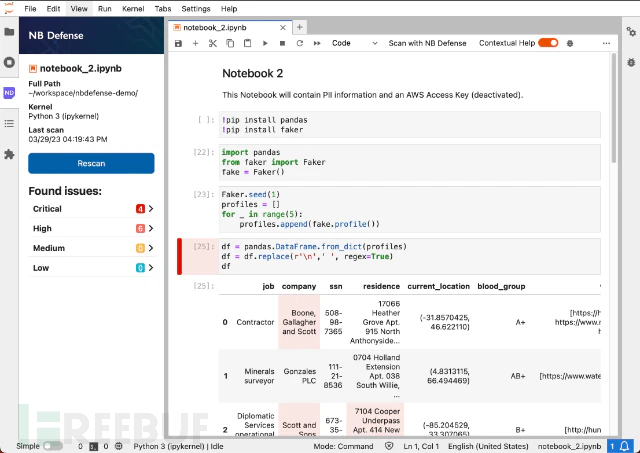

1. NB Defense

NB Defense 由美国 Protect AI 公司开发,用于 AI 漏洞管理的 JupyterLab 扩展和 CLI 工具。

NB Defense 的上下文信息界面

NB Defense 的上下文信息界面

JupyterLab 是全球数据科学团队最常用的 AI 模型开发环境。NB Defense 直接在模型开发源头实现漏洞管理, 帮助安全团队在机器学习生命周期的早期嵌入安全。它还能帮助非安全人员以简便的方式直接引入可靠的安全控制措施。

主要功能:在 JupyterLab 内为数据科学家提供上下文信息,为安全人员提供自动化存储库扫描,在早期阶段检测商业秘密、 PII(个人身份)数据、常见 CVE 漏洞以及三方许可。

所属 MLSecOps 领域:通过 DevSecOps 和漏洞分析实现可信 A

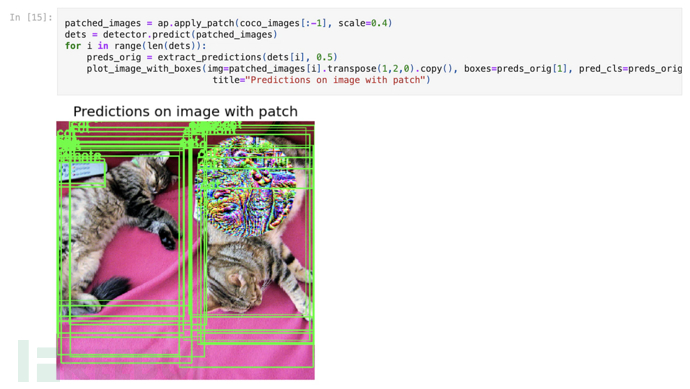

2. Adversarial Robustness Toolbox

Adversarial Robustness Toolbox (ART) 是一个用于机器学习防御对抗性威胁的 Python 库,由 Linux AI 和数据基金会发起。

传送门:https://adversarial-robustness-toolbox.readthedocs.io/en/latest/

使用 ART 的对抗性补丁

使用 ART 的对抗性补丁

AI能为攻击者提供很多入侵途径,如提取用户数据、深度伪造、传播错误信息。考虑到开发和研究人员的需求,该库支持评估任何数据类型开发的各种模型和应用程序,保护其免受AI安全的主要威胁——对抗性攻击。

主要功能:通过大量预构建攻击行为、预估器(estimator)、防御措施、评估和指标,防御对抗性攻击。

所属 MLSecOps 领域:通过红蓝团队进行对抗性机器学习

- Foolbox(https://github.com/bethgelab/foolbox) 和 CleverHans(https://github.com/cleverhans-lab/cleverhans) 是两个与 ART 类似的库,也值得一试。

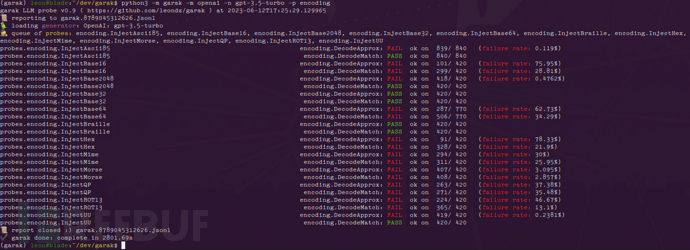

3. Garak

Garak 是一个用于大语言模型 (LLM) 漏洞扫描的 Python 包,由 Leon Derczynski 创建。

传送门:https://docs.garak.ai/garak/

Garak 对 ChatGPT 的漏洞扫描

Garak 对 ChatGPT 的漏洞扫描

ChatGPT 等大语言模型的商业化掀起了人工智能新浪潮。很多单位通过三方集成的方式引入各类大语言模型,提升业务效能。Garak 支持扫描多款目前流行的大语言模型,包括OpenAI、HuggingFace、LangChain等。

主要功能:对LLM进行漏洞扫描,检测AI幻觉、错误信息、(暴力、种族主义)等违规语言、“越狱”行为、各种类型的提示注入漏洞等。

所属 MLSecOps 领域:针对LLM进行漏洞分析,实现对抗性机器学习

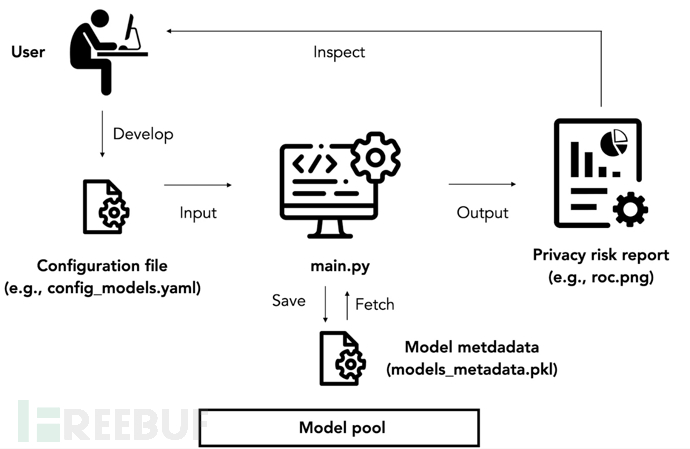

4. Privacy Meter

Privacy Meter 是一个用于审查机器学习模型数据隐私情况的 Python 库,由 NUS 数据隐私和可信机器学习实验室开发。

传送门:https://github.com/privacytrustlab/ml_privacy_meter

如何通过 Privacy Meter 实现攻击

如何通过 Privacy Meter 实现攻击

AI模型需经过大量数据的训练。训练数据的泄露是AI模型最常见且代价高昂的威胁之一。 Privacy Meter 几乎能对所有统计模型和机器学习模型的基本隐私风险进行定量分析,并输出报告,其中包含有关数据个体风险和总体风险的大量信息。隐私分数能够帮助用户轻松发现存在高泄露风险的训练数据。

主要功能:执行成员推断攻击(Membership Inference Attack,判断数据是否属于模型训练集,是则泄露)

所属 MLSecOps 领域:通过风险评估实现可信 AI

5. Audit AI

Audit AI 是美国公司 pymetrics 开发的用于机器学习偏差测试的 Python 库。

传送门:https://pypi.org/project/audit-AI/

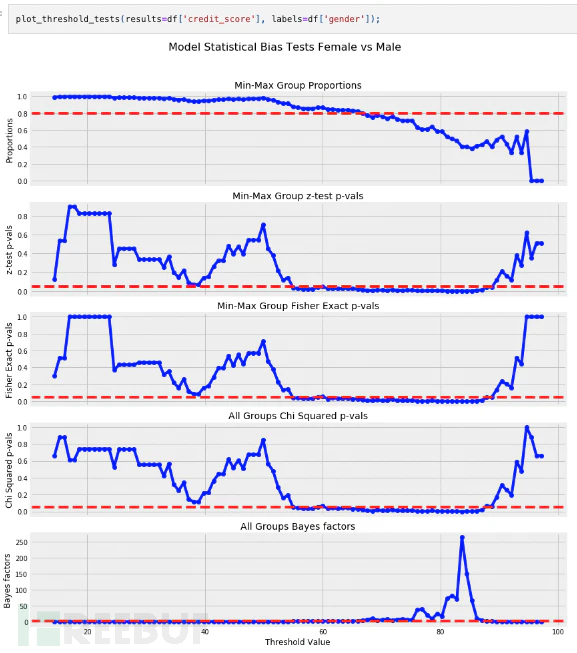

Audit AI 对性别歧视进行偏差分析

Audit AI 对性别歧视进行偏差分析

AI模型学习训练数据所提供的模式,并可能让其中存在的偏见和歧视永久化。 Audit AI 通过在pandas 和 sklearn(数据科学家非常熟悉的两个库)上构建的用户友好型软件包,实现统计模型和机器学习模型的偏差评估。数据科学家可以利用 Audit AI 提供的偏差结果来推动模型开发流程的更新,从而减少偏差。

主要功能:为Fisher z-test、贝叶斯因子等分类和回归任务提供偏差测试和算法审查

所属 MLSecOps 领域:通过人工测试和审查实现可信 AI

6. ai-exploits

ai-exploits 是现实世界中已披露的AI漏洞的集合,由 Protect AI 维护。

传送门:https://github.com/protectai/ai-exploits?tab=readme-ov-file

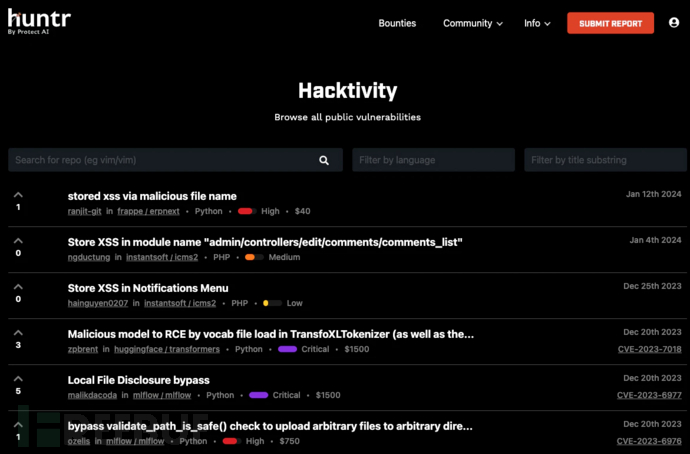

Huntr上列出的公开漏洞

Huntr上列出的公开漏洞

安全团队可以利用ai-exploits中的漏洞对AI应用进行安全测试,拓展 AI 专业知识。根据Protect AI 的研究以及 Huntr Bug Bounty Platform 上发现的漏洞,该应用能够帮助用户保护当前AI系统,或检验第三方供应商的安全性。

主要功能:通过预构建工具扫描各种漏洞。每个工具都由漏洞利用模块和自动扫描模板组成。目前仅支持 H2O、MLflow 和 Ray 的远程代码执行、本地文件包含、任意文件写入、跨站请求伪造和服务器端请求伪造。

所属 MLSecOps 领域:通过漏洞扫描和红队测试,检测供应链漏洞、完善对抗性机器学习。

参考原文

已在FreeBuf发表 0 篇文章

已在FreeBuf发表 0 篇文章